Rauschen

Kodak hat ein neues Sensorkonzept vorgestellt, bei dem die Hälfte der Pixel nur noch eine Helligkeits- aber keine Farbinformation mehr liefern. Das Ziel sind rauschärmere Fotos trotz immer kleinerer Pixel. Die Idee zu einem Sensor mit "transparenten" Pixeln ist zwar älter als Kodaks "Juni-Meldung" den Anschein erweckt, sie hat aber das Potential in zukünftigen Kameras zu besseren Bildern bei schlechten Lichtverhältnissen zu führen. Dies gilt insbesondere dann, wenn die Kameras mit einem "kleinen Sensor" ausgestattet sind. Kodak hat in Amerika offensichtlich ein Patent auf die Idee angemeldet, was in Deutschland - in der Regel - unmöglich wäre, wenn jemand anderes die Idee bereits veröffentlicht hat. Das Patent und die entsprechenden Lizenzabgaben könnten verhindern, dass sich der neue Sensortyp großflächig durchsetzt. Anderseits klingt das Konzept vielversprechend, wir werden sehen...

Im Juni hat Kodak eine interessante Idee zur Integration von "ungefilterten Pixeln" in einem Sensor für digitale Kameras vorgestellt. Bei einem klassischen 12-Megapixel-CCD sitzen vor 6 Mio. Pixeln winzige Grünfilter und vor je 3 Mio. Pixeln Rot- bzw. Blaufilter. Kodak schlägt nun vor, bei 6 Mi...

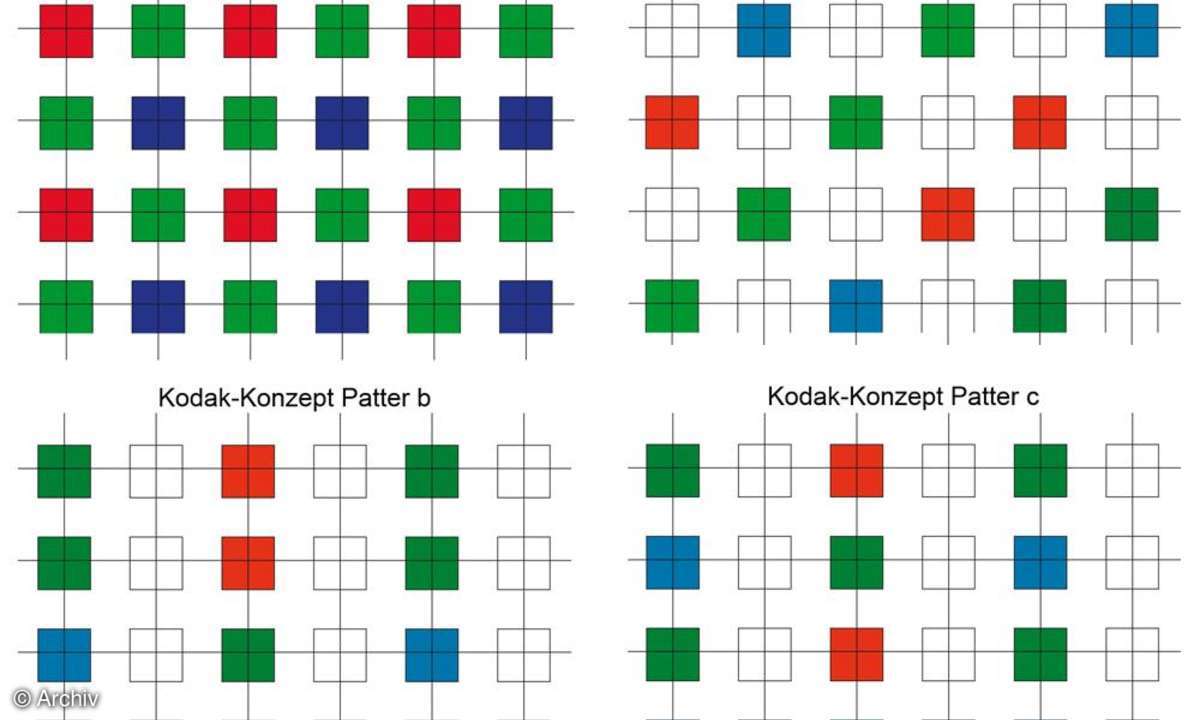

Im Juni hat Kodak eine interessante Idee zur Integration von "ungefilterten Pixeln" in einem Sensor für digitale Kameras vorgestellt. Bei einem klassischen 12-Megapixel-CCD sitzen vor 6 Mio. Pixeln winzige Grünfilter und vor je 3 Mio. Pixeln Rot- bzw. Blaufilter. Kodak schlägt nun vor, bei 6 Mio. Pixeln eines 12-Megapixel-Sensors ganz auf die Farbfilter zu verzichten. Das soll die Empfindlichkeit und damit das Rauschverhalten sowie die Bildqualität verbessern. Für die restlichen Pixel gälte die klassische Verteilung mit 50% Grün-, 25% Rot- und 25% Blaufiltern. Allerdings gibt es Zweifel, ob die Idee wirklich von den Kodak-Mitarbeitern John Compton und John Hamilton stammt, wie Kodak behauptet und "The online Photographer" berichtet (https://the onlinephotographer.typepad.com/the_online_photographer/ 2007/06/kodaks_brillian.html).

Dem Auge nachempfundenDas menschliche Auge verfügt über zwei Rezeptortypen: Stäbchen und Zapfen. Die Stäbchen sind sehr viel empfindlicher als die Zapfen, sie können aber nur Hell/Dunkel unterscheiden. Drei verschiedene Zapfentypen sind auf der Netzhaut zu finden, die zwar unempfindlicher sind, dafür aber drei verschiedene Farben unterscheiden können.

Bei schlechten Lichtverhältnissen sehen wir also nur die oft beschworenen "grauen Katzen". Haben wir mehr Licht zur Verfügung, rückt die Farbe ins Bild.

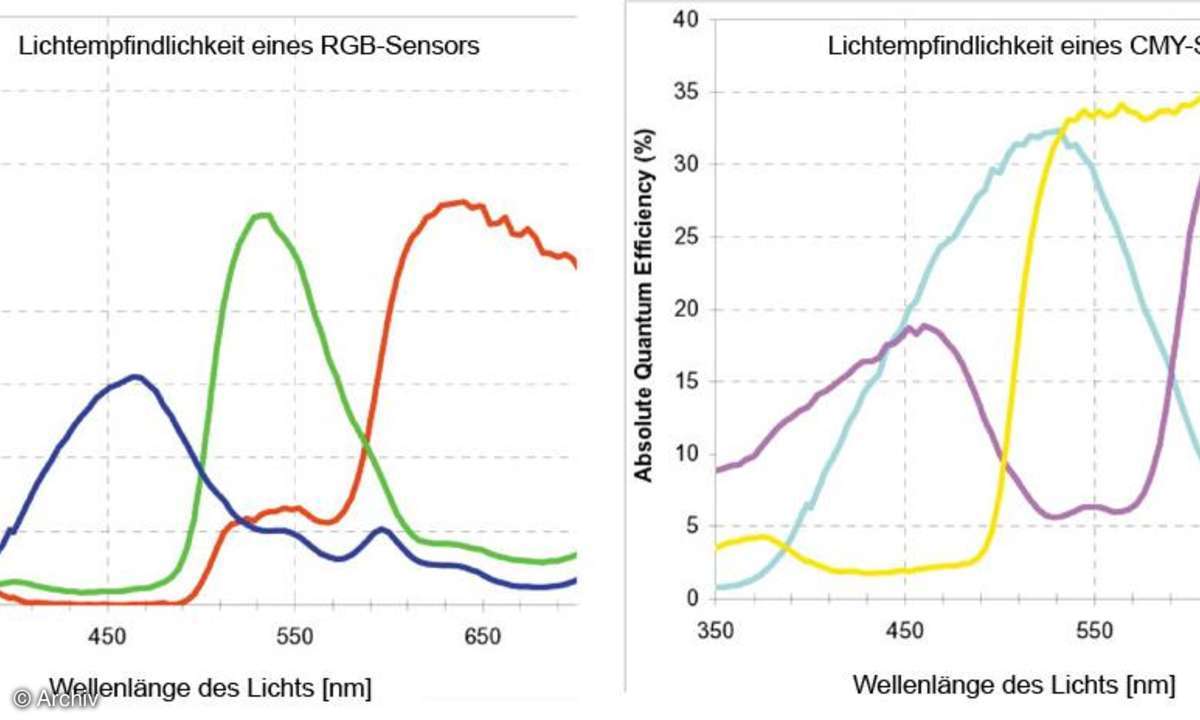

Analog zu diesem Vorgehen sollen die Sensoren digitaler Kameras zukünftig auch "panchromatische Pixel" bekommen, also Pixel, die für sichtbares Licht aller Wellenlängen empfindlich sind, was die Empfindlichkeit insgesamt erhöht. Zugleich steht damit die Frage im Raum, inwieweit zukünftig auch die natürliche Infrarotempfindlichkeit der Silizium-Sensoren genutzt wird. Bisher nutzen die meisten Sensoren eine Struktur von Rot-, Grün- und Blaufiltern (R, G, B), die jeweils vor dem einzelnen Sensor angebracht sind. Diese Struktur geht auf den Kodak-Mitarbeiter Dr. Bryce Bayer (1975) zurück. Die Filter lassen nur das Licht von jeweils einer Farbe, also Rot, Grün oder Blau durch. Dadurch sinkt natürlich die Menge an Licht, die auf dem jeweiligen Sensor ankommt. Das hat in der Vergangenheit dazu geführt, dass in vielen kompakten Digitalkameras mit kleinen Sensoren C-, M-, Y-Sensoren (Cyan, Magenta, Gelb) eingesetzt wurden, die pro Pixel jeweils zwei Farben, nämlich Grün und Blau bei Cyan, Rot und Blau bei Magenta sowie Rot und Grün bei Gelb durchlassen. Das entstandene CMY-Bild musste aber anschließend wieder in ein RGB-Bild umgerechnet werden, und diese Art der Filterung hat zu Problemen in der Farbwiedergabe geführt. In den letzten Jahren ist es um das CMY-Konzept deswegen wieder still geworden.

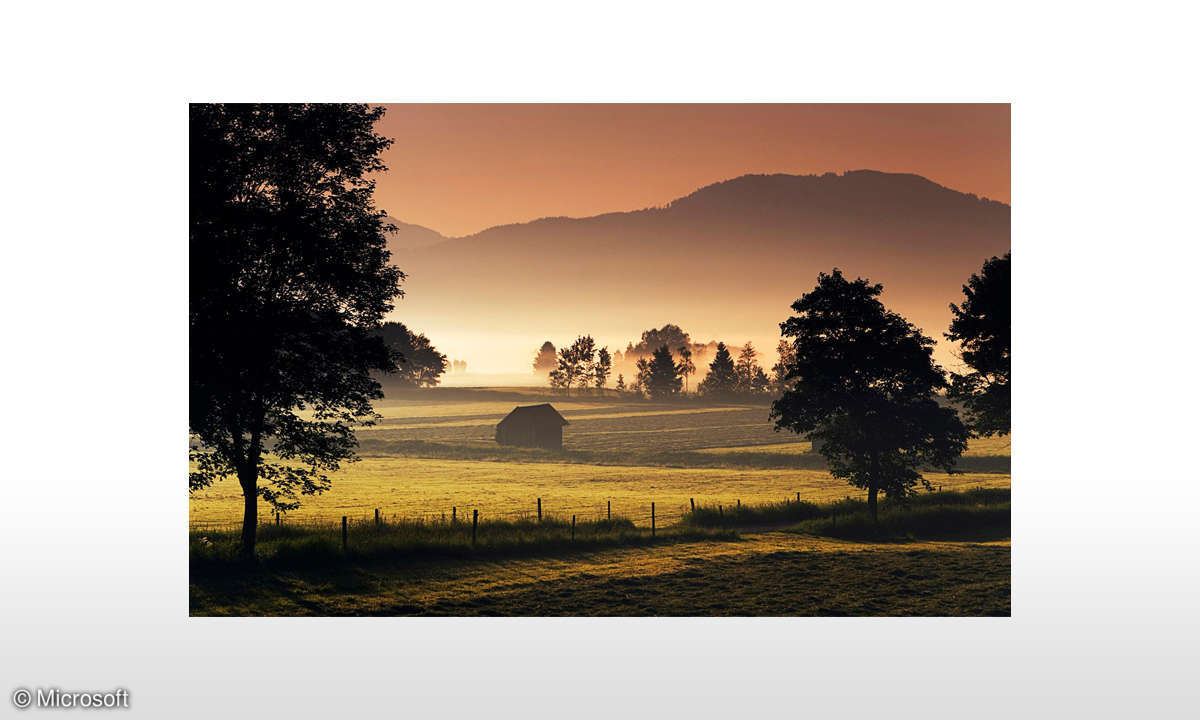

Die neue Idee ist nun, grundsätzlich RGB-Filter einzusetzen und zusätzlich die gleiche Anzahl Pixel ohne Filter hinzuzufügen, die alles Licht für die Aufzeichnung nutzen und damit sehr lichtempfindlich sind. Wie genau die Anordnung für die Filter aussehen soll, steht wohl noch nicht fest. Die Ausführungen von "imaging-resource" beschreiben drei verschiedene Grundtypen, die derzeit diskutiert und wohl erst 2008 realisiert werden. In allen drei Fällen sind 50% der Pixel filterlos, vor 25% sitzen Grün- und vor je 12,5% Blau- bzw. Rotfilter. Die Information aus den RGB-Pixeln wird bei dem neuen Sensor "nur noch" für die Farbinformation genutzt. Die aufkommende Frage ist: "Wird das Bild nicht schlechter, wenn Farbinformation fehlt?" Die Antwort lautet wie so oft: "Das kommt darauf an."Durch das teilweise Weglassen der Filter gewinnt man Empfindlichkeit, die bei schlechten Lichtverhältnissen zu weniger Bildstörungen (Rauschen) und damit zu besseren Bildern führt. Was auf der Strecke bleibt, ist die Farbinformation in feinen Strukturen. Das heißt nicht, dass das Bild weniger bunt wird, sondern nur, das an farbigen Kanten die Farbe verwischt.

Nun holt sich das menschliche Auge die Detailinformation und damit die Schärfe aus der Helligkeit. Die Farbinformation braucht in der Regel nicht so detailliert zu sein, um ein gutes Bild zu ergeben. Eine Tatsache, die sich sowohl das Fernsehen als auch die verschiedenen Kompressionsverfahren für Bilder zunutze machen.

So interessant das Konzept klingt, gibt es doch berechtigte Zweifel, dass die Idee zu den transparenten Pixeln tatsächlich ursprünglich von Kodak stammt. So hat der Harvard-Absolvent Gang Luo im Januar 2007 auf der Electronic Imaging Conference in San Jose einen Vortrag zu diesem Thema gehalten, zu dem die Idee bereits in einem Abstract im Sommer 2006 formuliert sein musste, also knapp ein Jahr vor Kodaks Ankündigung. Luos Prinzip und Beispielbilder sind seit Dezember 2006 im Internet abrufbar unter: https://mysite.verizon.net/vzeu5f6h/pic turescapturedusing anovelcfa/