Künstliche Intelligenz: Chatbot wird böse

- Künstliche Intelligenz: Gefahren und Chancen

- Künstliche Intelligenz: Chatbot wird böse

- Künstliche Intelligenz: KI und Super-KI

Nicht wirklich gefährlich, aber lehrreich ist der Fall des Microsoft Chatbots Tay. Die Software kann aus den Gesprächen von Menschen lernen, wie man richtig chattet, und soll so mit der Zeit zu einem immer besseren Gesprächspartner werden. Angreifer fütterten Tay jedoch gleich nach der Einf�...

Nicht wirklich gefährlich, aber lehrreich ist der Fall des Microsoft Chatbots Tay. Die Software kann aus den Gesprächen von Menschen lernen, wie man richtig chattet, und soll so mit der Zeit zu einem immer besseren Gesprächspartner werden. Angreifer fütterten Tay jedoch gleich nach der Einführung im März 2016 mit rassistischen, sexistischen und anderen unerwünschten Äußerungen.

Tay mutierte daraufhin zum Hitler-Fan und postete Hass-Parolen, bis sie von den Microsoft-Entwicklern eilig vom Netz genommen wurde. Fehler können sich also nicht nur in der Planungsphase eines KI-Systems einschleichen wie bei den autonomen Autos. Lernende Systeme können falsches Verhalten in der Praxis lernen und dadurch zu einem echten Risiko werden.

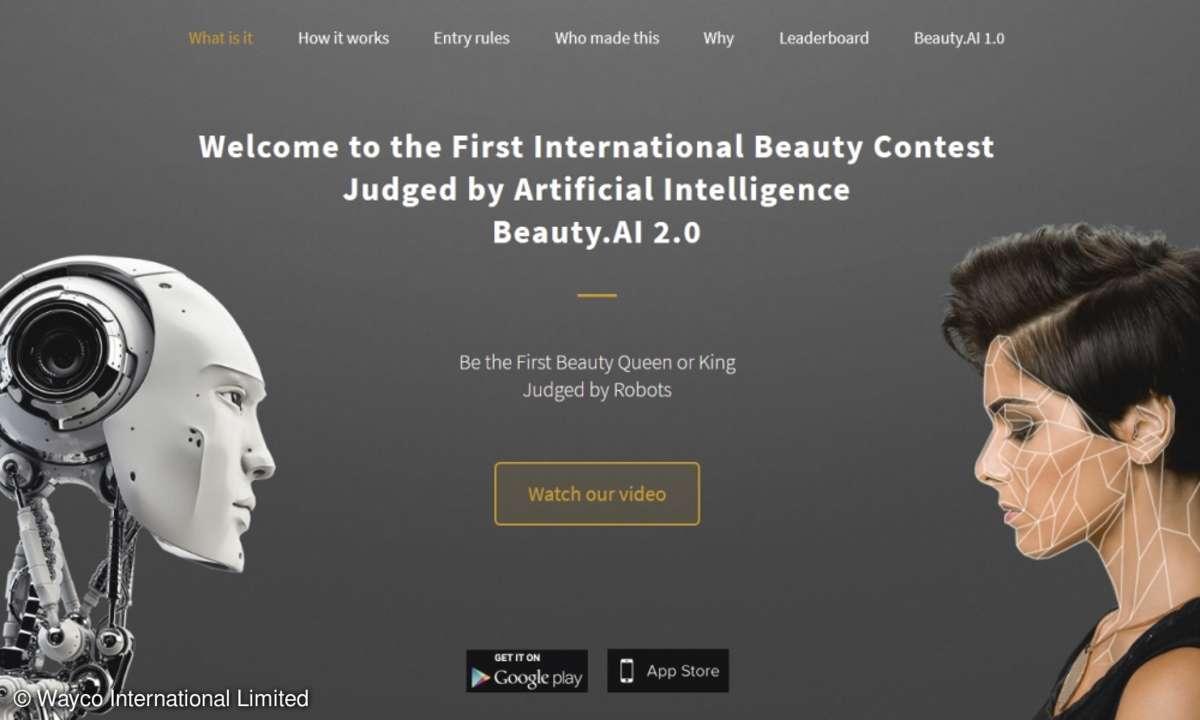

Wie vorsichtig man beim KI-Training sein muss, zeigt ein weiterer Fall. Bei dem Schönheitswettbewerb Beauty.AI Anfang 2016 sollte eine künstliche Intelligenz aus eingeschickten Fotos die schönsten Männer und Frauen auswählen. Dabei wählte die Software hauptsächlich Weiße und Latinos aus und zeigte dabei eine Abneigung gegen dunkle Haut.

Im Fall eines Schönheitswettbewerbs kann man solche Schnitzer vielleicht belächeln. Weniger witzig ist es, wenn eine durch Training oder entsprechende Algorithmen "voreingenommene" künstliche Intelligenz Kandidaten für Bewerbungsgespräche auswählt, die Kreditwürdigkeit von Kunden abschätzt oder politische Postings in sozialen Netzwerken bewertet.

Diese Probleme sind den Wissenschaftlern bewusst. Forscher wie zum Beispiel Roman Yampolskiy beschäftigen sich damit, wie man selbst lernende Systeme, deren Verhalten per Definition schwer vorhersagbar ist, sicher gestalten kann.

Gefahr durch Superintelligenz

Sollte es Forschern gelingen, eine Superintelligenz zu entwickeln, könnte das ein echter Gewinn für die Menschheit sein. Vielleicht löst diese Superintelligenz Probleme, an denen die Menschheit seit Jahrzehnten oder Jahrhunderten vergeblich arbeitet. Eine Superintelligenz könnte sich aber auch gegen die Menschheit wenden oder die Menschen einfach links liegen lassen.

Das Problem ist nach Ansicht von Wissenschaftlern wie Nick Bostrom oder Eliezer Yudkowsky, dass wir keine Ahnung haben, wie das Wesen einer solchen Superintelligenz sein wird. Eins steht fest: Eine Superintelligenz wird von Menschen nur schwer kontrollierbar sein. Die kleine Denksportaufgabe von Stuart Armstrong soll das illustrieren.

Deshalb sollen schon jetzt wissenschaftliche Verfahren entwickelt werden, die sicherstellen, dass eine kommende Superintelligenz uns freundlich gesonnen ist (Friendly AI, freundliche KI) und keinen Schaden über die Menschheit bringt. Möglicherweise indem sie sich an Asimovs Robotergesetze hält. An dieser Aufgabe arbeiten die am Anfang des Artikels erwähnten Institute.

Die Zeit drängt. Denn eine Superintelligenz ist – wie die Atombombe – eine Technik, die jeder haben will. Laut New York Times hat zum Beispiel China ein 150-Milliarden-Dollar-Programm aufgelegt, um bis 2030 Weltführer auf dem Gebiet der KI zu sein. Wann der Technikdurchbruch, der uns eine Superintelligenz beschert, kommen wird, kann niemand vorhersehen. Bis dahin sollte die Technik so weit sein, dass diese Superintelligenz auch "freundlich" ist.