Viren-Attacke mit KI

Das Wettrüsten geht weiter: Der nächste technologische Schritt im Krieg Erpresser gegen Virenjäger lautet künstliche Intelligenz.

- Viren-Attacke mit KI

- Fachbegriffe aus der künstlichen Intelligenz

Der Erpressertrojaner Emotet hielt die IT-Welt zwischen 2014 und 2021 in Atem und überraschte die Virenspezialisten immer wieder mit neuen, perfiden Strategien. Unlängst zerbrachen sich Analysten der Sicherheitsfirma Eset den Kopf, warum sich neuere Emotet-Varianten im Labor nicht mehr fassen lie�...

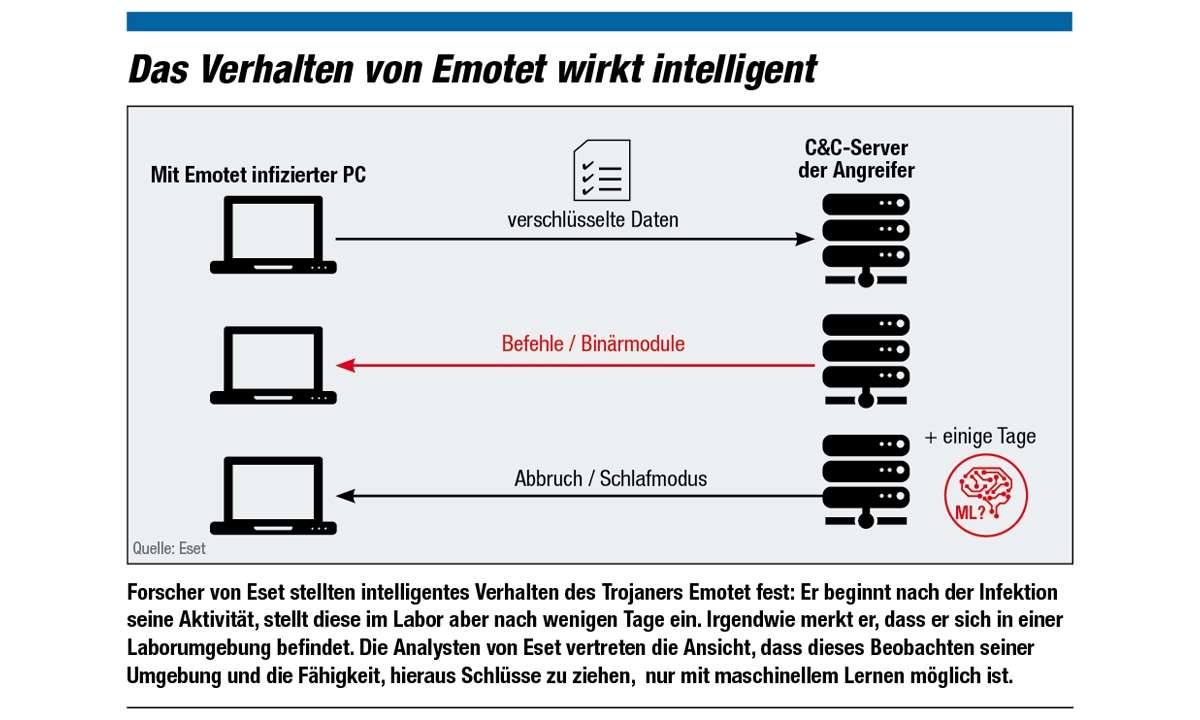

Der Erpressertrojaner Emotet hielt die IT-Welt zwischen 2014 und 2021 in Atem und überraschte die Virenspezialisten immer wieder mit neuen, perfiden Strategien. Unlängst zerbrachen sich Analysten der Sicherheitsfirma Eset den Kopf, warum sich neuere Emotet-Varianten im Labor nicht mehr fassen ließen. Die Schädlinge befielen zwar die Testrechner, aber verweigerten dort jegliche Aktivität; wie hungrige Laborratten, die statt zum Köder zu eilen, sich einfach schlafen legen.

Bei genaueren Untersuchungen ergab sich dann, dass Emotet, sobald er sich eingenistet hatte, große verschlüsselte Datenmengen an seine (inzwischen abgeschalteten) Control- und Command-Server schickte . Dort wurden die Daten offensichtlich analysiert, und der Trojaner bekam Feedback, wie er sich verhalten soll. Die Sicherheitsforscher beobachteten sogar, dass Emotet anfänglich aktiv wurde und erst im Laufe der Zeit in den Schlafmodus fiel.

Das bedeutet, dass der Trojaner ständig seine Umgebung beobachtete und Schlüsse daraus zog. Die Analysten nehmen daher an, dass die Betreiber von Emotet mit maschinellen Lernalgorithmen arbeiteten: „Derartige Abläufe wären ohne Automatisierung kaum realisierbar. Die hinter Emotet stehenden Angreifer müssten massiv Ressourcen aufwenden, um die Malware zu steuern.

“ Mit Methoden der künstlichen Intelligenz (KI) lässt sich das Verhalten der Malware „mit einem Bruchteil der Ressourcen und wesentlich schneller implementieren.“ (Machine Learning White Paper, Feb. 2019). Die Erpresser und Kontoräuber sparen also Geld, wenn sie Methoden der künstlichen Intelligenz verwenden.

Big Data erzwingt KI

Im ewigen Kampf zwischen Gut und Böse rüsten beide Seiten auf. Bei den Guten ist es die schiere Masse an Daten, welche die Firmen geradezu dazu zwingt, KI einzusetzen. Jeden Tag kommen Tausende neuer Schädlinge hinzu. Microsoft schreibt im Digital Defense Report September 2020: „Unsere Sicherheitslösungen verarbeiten täglich mehr als acht Billionen digitale Signale, um mithilfe von künstlicher Intelligenz und Machine Learning Cyberbedrohungen frühzeitig zu erkennen und abzuwehren.“ Im Detail sind das mehr als 470 Milliarden E-Mails, 18 Millionen URLs und 600 Milliarden Dokumente – täglich.

„Eine Analyse solcher Datenmengen ist sowohl durch die menschliche Auffassungsgabe als auch durch Standard-Algorithmen nicht mehr beherrschbar“, bewertet Sven Krasser, Chief Scientist bei der Sicherheitsfirma Crowdstrike, die Lage. Die Firma ist auf KI in der Sicherheit spezialisiert.

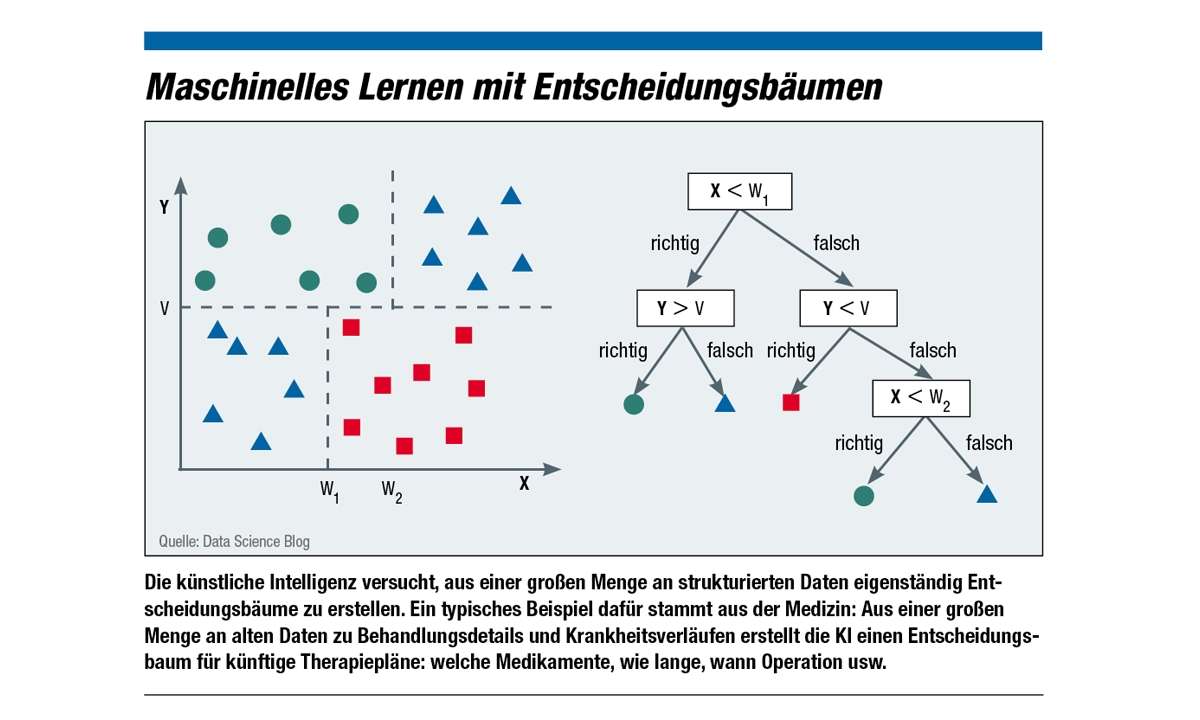

Auch hier arbeiten die Experten mit Big Data: „Zum Trainieren unserer Modelle nutzen wir fünf Billionen Datensätze“, berichtet Krasser. Dabei kommen verschiedene Methoden der KI zum Einsatz. Viele Menschen denken bei KI zuerst an neuronale Netze oder Deep Learning; für strukturierte Daten bieten sich aber auch andere Methoden an, zum Beispiel Entscheidungsbäume (siehe Glossar und Grafik).

Strukturierte Daten in der Sicherheit sind zum Beispiel Dateien. Jede Datei verfügt über eine große, aber begrenzte Zahl an Eigenschaften wie Typ, Größe, Herkunft, Hash-Wert, binäre Struktur, Entropie (Datendichte) und ähnliches. Die Forscher trainieren aus diesen Eigenschaften ein KI-Modell, das selbstständig einen Entscheidungsbaum bzw. Random Forest erstellt, der neue Dateien klassifiziert.

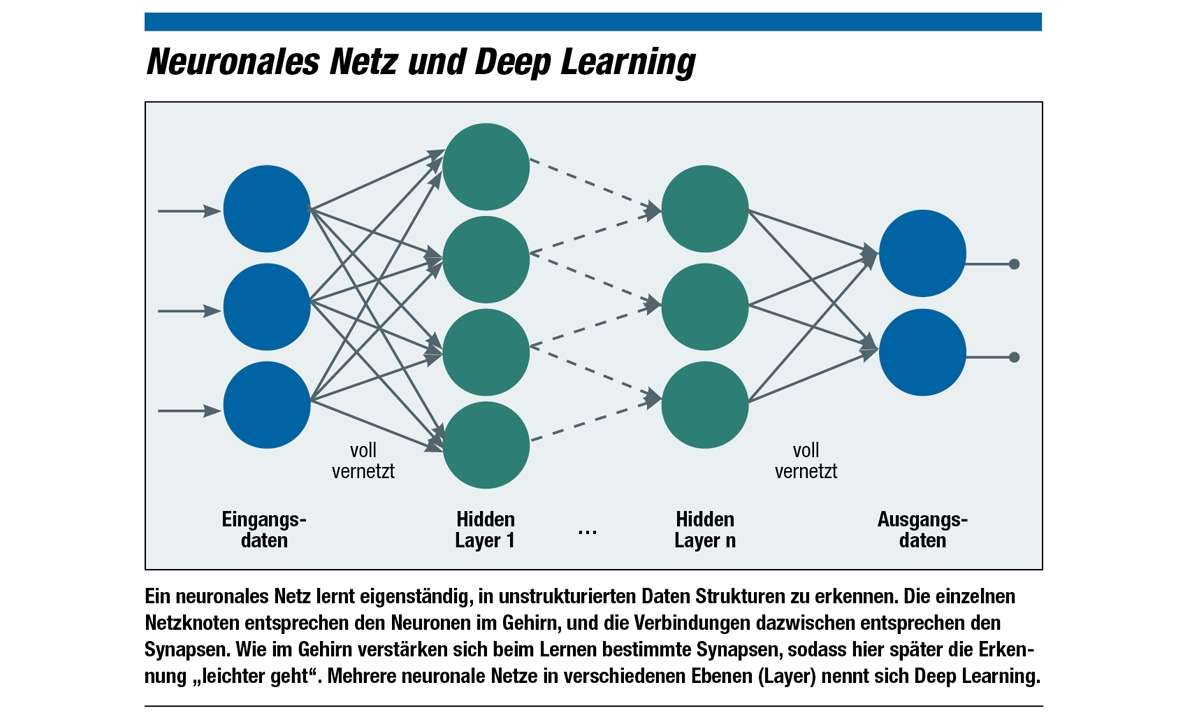

Aber neuronale Netze oder Deep Learning kommen auch zum Einsatz, um die Datenmengen zu beherrschen: bei unstrukturierten Daten, wo die Forscher ein Modell trainieren, ohne zu wissen, wieso die Maschine am Schluss zu ihrem – oft richtigen – Ergebnis kommt. Bekanntestes Beispiel: die Bilderkennung, bei der Forscher etwa ein Modell auf das Erkennen von Verkehrszeichen optimieren und dann im autonomen Auto einsetzen. Die KI lernt, aus der wilden Masse bunter Punkte ein ausgebleichtes, vom Gebüsch halb verdecktes Vorfahrtsschild zu erkennen. Nach welchen Kriterien sie dabei vorgeht, bleibt ihr Geheimnis.

Auch im Sicherheitsbereich gibt es unstrukturierte Daten: Piktogramme in Dateien, also eingebettete Icons, oder Text. „Viele Dateien enthalten Zeichenketten, die sich mit neuronalen Netzen analysieren lassen. Die Ergebnisse können wir wiederum als Kriterien für Entscheidungsbäume verwenden“, erklärt Krasser von Crowdstrike.

Etwas kritischer gibt man sich bei der Sicherheitsfirma Trend Micro, was den Einsatz neuronaler Netze anbelangt: „Wir müssen unseren Kunden sagen können, wie Entscheidungen zustande gekommen sind“, gibt Jonathan Oliver, Data Scientist bei Trend Micro, zu bedenken. Dennoch arbeitet die Firma damit: „Deep Learning ist aber beispielsweise sehr gut darin, das Verhalten von Malware in einer Sandbox zu bewerten.“

Mit oder ohne neuronalem Netz: Das trainierte KI-Modell landet schließlich auf dem Client des Anwenders und wird dort auf neue, unbekannte Dateien oder Prozesse losgelassen (Inferenz). „Die Erkennungsrate liegt deutlich höher als bei klassischer Heuristik“, lobt Krasser den intelligenten Virenwächter. Und auch Oliver von Trend Micro kommt zum Fazit: „Das Potenzial von AI ist groß; es ist eine der Schlüsseltechnologien in der Erkennung von Malware und Angriffen.“ Hier sind sich die Experten einig.

Intelligente Angriffe sind noch nicht stark verbreitet

Die organisierten Cyber-Verbrecher sind gezwungen, technisch mitzuhalten; wie Schmuggler, die ihre Boote aufrüsten müssen, wenn sich die Küstenwache schnellere zugelegt hat. Ansonsten funktioniert ihr Business-Modell nicht mehr. Emotet war ein erstes Beispiel dafür, denn KI ist teuer. Aber bei Emotet stimmte die Kasse: Gezielte Erpressung, also nicht breit gestreut, sondern auf ein bestimmtes, finanzstarkes Opfer ausgerichtet, bringt den Tätern den größten Reingewinn. Investitionen lohnen sich hier also.

Aber: „Die Verwendung von AI für die Verbesserung der Effizienz von Malware steckt in den Kinderschuhen“, bewertet ein White Paper von Trend Micro die Verbreitung von intelligenten Angriffstechniken in der Unterwelt (Malicious Uses and Abuses of Artificial Intelligence, 2020). Die Forscher sind für diesen Bericht in Untergrundforen auf die Suche nach schon bei Hackern im Einsatz befindlichen KI-Systemen gegangen. Gefunden haben sie Tools, die Passwörter knacken, Capchas auflösen oder Verschlüsselungen dechiffrieren.

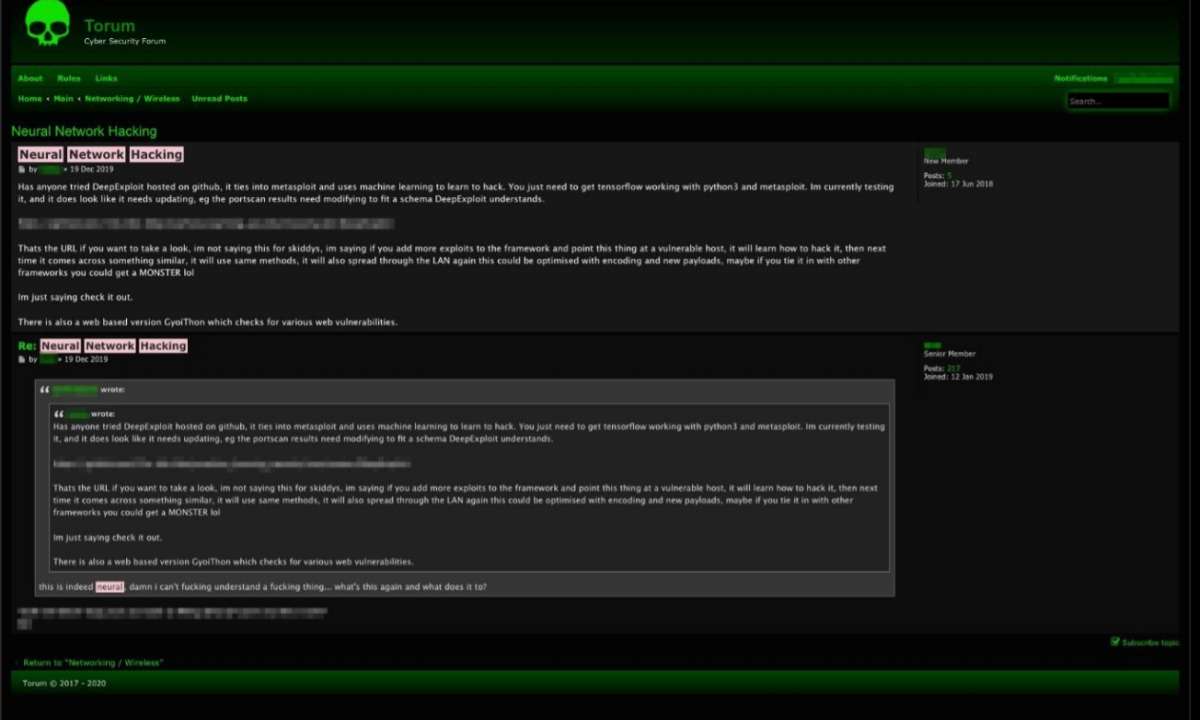

Viele andere Möglichkeiten für kriminelle KI werden in den Foren diskutiert, etwa Game-Cheats, Bitcoin-Mining, Social Engineering und KI-Hacking. Für letzteres gibt es bereits zwei Anwendungen, die versuchen, in Systeme einzudringen: DeepHack und DeepExploit. Beide werden mit erfolgreichen Hacks und Exploits für ihre Angriffe trainiert. DeepExploit arbeitet sogar mit dem gängigen, kommerziellen Penetration-Test-Tool Metasploit zusammen.

Sicherheitsexperten fürchten, dass künftig immer mehr KI-Methoden im Einbruchswerkzeugkasten des organisierten Verbrechens landen, sofern die Kosten sich für die Ganoven lohnen. Maschinen können optimierte Inhalte generieren wie Phishing-Seiten oder Spam-Nachrichten, die sowohl Menschen als auch Erkennungs-Algorithmen täuschen.

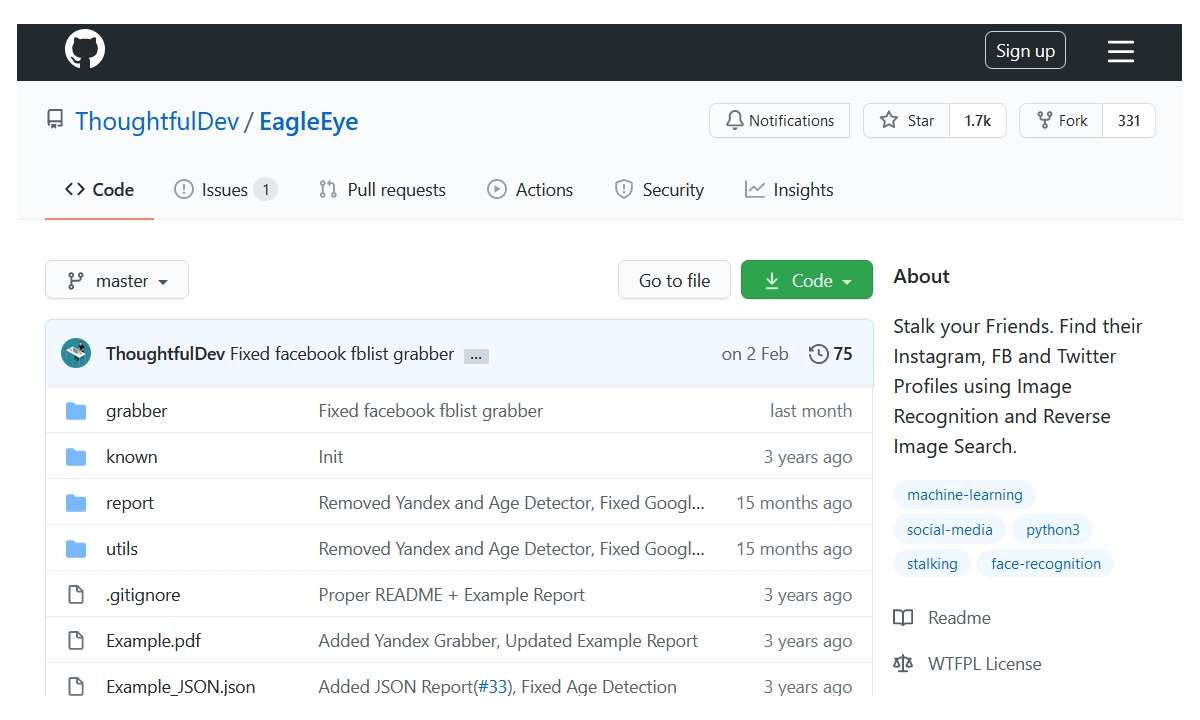

Besondere Gefahren ergeben sich aus maschinenoptimierten sozialen Attacken – das war ebenfalls eine Stärke von Emotet: gezielt eingesetzte Mails, die beim Anwender kein Misstrauen wecken. Die Autoren des Trend-Micro-Papers warnen im Zusammenhang mit sozialen Attacken beispielsweise vor dem Tool Eagle Eyes, das mit KI sämtliche Social-Media-Accounts einer Person zu finden versucht, auch die unter Pseudonymen. Dafür verwendet es Deep Learning bei der Gesichtserkennung von Profilbildern.

Auch das sowieso schon stark in Verruf geratene Tool Deep Fake, das mit KI täuschend echt fremde Gesichter in Filme montiert, lässt sich für soziale Attacken zweckentfremden. Zu den Bildern lassen sich Stimmen mit KI so modulieren, dass sie etwa einen bestimmten Dialekt annehmen.

Die Möglichkeiten zur Täuschung von Menschen und Maschinen, die sich aus diesen Techniken ergeben, sind immens: „Hier ist Alice aus der EDV, bitte setz Dein Passwort zurück, ich schick Dir gleich den Link ...“, am Telefon erklingt die fränkische Stimme von Alice.

In echt spricht Mallory mit seinem schottischem Akzent, aber keiner merkt’s. Das Fazit der Autoren lautet: „Kriminelle nutzen wahrscheinlich KI, um ihre Attacken zu erleichtern, um die Aussichten auf Profit in kürzerer Zeit zu optimieren, um mehr Opfer auszubeuten und um neue, innovative Geschäftsmodelle zu kreieren – all das, während es ihre Chancen, erwischt zu werden, verringert.“

Kampf Maschine gegen Maschine

Gehen wir letztendlich in puncto Sicherheit einer Auseinandersetzung zwischen Computern untereinander entgegen? Vieles spricht dafür, dass das in einigen Bereichen stattfinden wird oder teilweise schon der Fall ist. Ein Beispiel sind sogenannte Adversarial Attacks, also Angriffe, die darauf abzielen, ein KI-Modell zu überlisten und in die Irre zu führen (wie auf dem Stoppschild auf der ersten Seite). Adversarial Attacks können nun automatisiert werden, um – negativ gesehen – einen KI-Schutz zu überwinden. Positiv betrachtet, setzen Sicherheitsforscher selbst automatisierte Adversarial Attacks ein, um Modelle zu verbessern.

Ein Beispiel hierfür ist das Tool PassGAN, das Vorschläge für sichere Passwörter macht. Dafür erzeugt es mit Deep Learning ein KI-Modell durch die Auswertung der statistischen Verteilung von Millionen echten Passwörtern. Diese enorme Kennwortsammlung gewinnt es aus den vielen, in letzter Zeit bekannt gewordenen und veröffentlichten, großen Passwort-Leaks.

Das KI-Modell ist nun in der Lage, gute (= seltene) Passwörter zu erkennen. Das Adversarial-Element im anderen Computer erfindet nun Passwörter und schlägt sie dem KI-Modell vor, das sie wiederum bewertet. Die aus diesem Prozess gewonnen Kennwörter sind statistisch sehr sicher und quasi aus dem Leben gewonnen.

Auch die bösen Buben verwenden solche sogenannten Generative Adversarial Networks (GANs), um statistisch häufiger auftretende Passwortvorschläge für eine Brute-Force-Attacke zu generieren. Die Verbesserung liegt dabei bei über 50 Prozent mehr Treffern gegenüber gängigen Passwort-Crackern wie Hashcat. Bei GANs trainiert also eine KI die andere, indem sie Attacken simuliert, welche die andere abfangen muss. Das hat etwas von R2D2 und C3PO, die sich bei Krieg der Sterne alleine in der Wüste zurechtfinden müssen

Schaffen es die Maschinen künftig alleine?

Menschen werden aber auch in Zukunft nicht überflüssig sein. Ein Blog-Beitrag von F-Secure bringt das auf den Punkt (Aug. 2017): „Menschliche Einblicke und Wissen sind notwendig, um zu erkennen, wie groß die Tragweite einer identifizierten Gefahr ist. Außerdem können nur Menschen einen Plan entwickeln, wie auf diese spezifischen Szenarien reagiert werden muss, sich einen Überblick schaffen und mit der KI zusammen an der perfekten Lösung arbeiten.“