Machine Learning

Wird ChatGPT schlechter?

Eine Studie stellt vermehrt Fehler in ChatGPT fest. Lernt KI nicht ständig dazu? Eine Betrachtung über die Herausforderungen des KI-Tools.

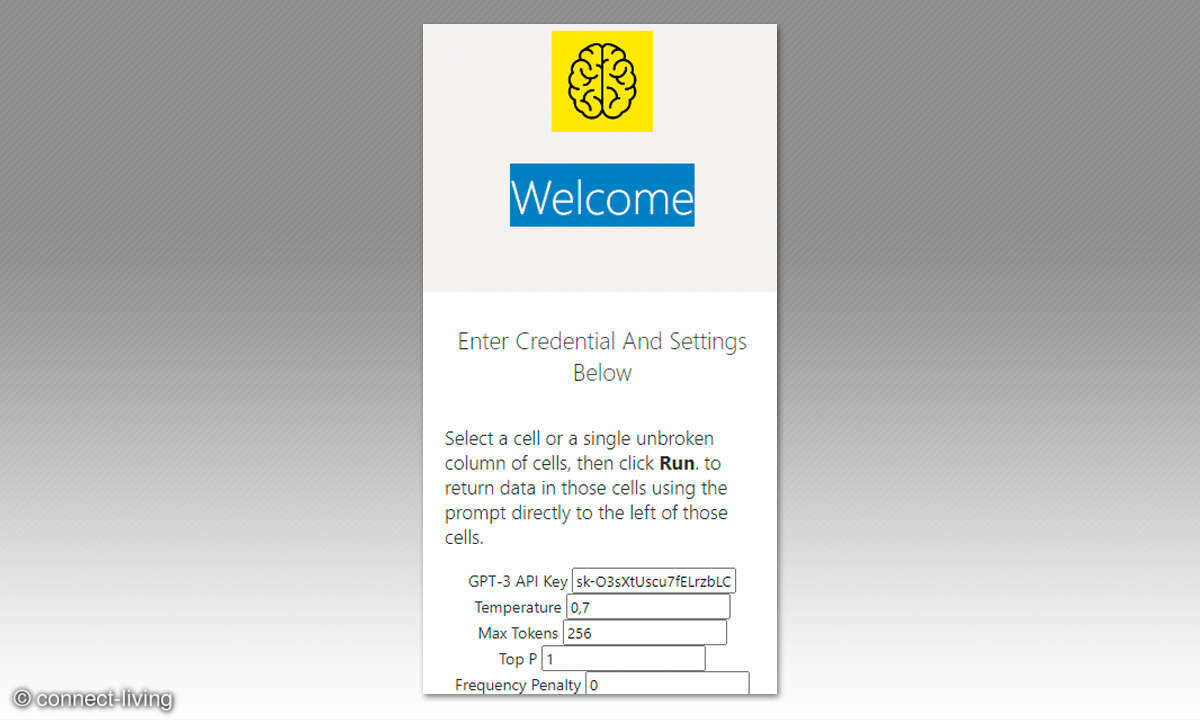

ChatGPT ist ein KI-Chatbot, der darauf ausgelegt ist, menschliche Texteingaben zu verstehen und so natürlich wie möglich zu antworten. Der Bot verfügt über eine Vielzahl von Fähigkeiten, darunter das Beantworten von Fragen, das Verfassen von Gedichten, das Erstellen von Social-Media-Posts, das ...

ChatGPT ist ein KI-Chatbot, der darauf ausgelegt ist, menschliche Texteingaben zu verstehen und so natürlich wie möglich zu antworten. Der Bot verfügt über eine Vielzahl von Fähigkeiten, darunter das Beantworten von Fragen, das Verfassen von Gedichten, das Erstellen von Social-Media-Posts, das Generieren von Codezeilen, das Zusammenfassen von Texten und vieles mehr.

Forscher der Stanford University und der UC Berkeley haben in der Studie "Veränderungen im Verhalten von ChatGPT im Laufe der Zeit" die Antworten verschiedener GPT-Generationen über mehrere Monate untersucht. Das Ergebnis ist überraschend: GPT scheint sich mit der Zeit zu verschlechtern.

Aufgrund seiner Modellstruktur ist ChatGPT nicht fehlerfrei und liefert nicht immer präzise Antworten. Es kann auch Schwierigkeiten haben, den Kontext und Nuancen in Gesprächen zu verstehen, was manchmal zu unbeabsichtigt komischen oder unpassenden Antworten führen kann.

Was sind die Ergebnisse?

Large Language Models-Dienste (LLM) wie GPT-4 und GPT-3.5 werden häufig verwendet. Wann und wie diese Modelle im Laufe der Zeit aktualisiert werden, ist jedoch undurchsichtig.

Im Zeitraum zwischen März und Juni 2023 haben die Forscher explizit vier verschiedene Aufgaben bei ChatGPT untersucht: Lösen mathematischer Probleme, Beantworten sensibler Fragen, Generieren von Code und visuelles Denken.

Die Leistungen des GPT-4 und des GPT-3.5 können im Laufe der Zeit erheblich variieren und sich bei einigen Aufgaben sogar verschlechtern: Im Laufe der Zeit haben sich bemerkenswerte Leistungsunterschiede gezeigt. Zum Beispiel war GPT-4 (März 2023) sehr erfolgreich im Erkennen von Primzahlen mit einer Genauigkeit von 97,6 %. Allerdings zeigte GPT-4 (Juni 2023) bei denselben Fragen eine sehr schlechte Leistung mit einer Genauigkeit von nur 2,4 %.

Zusammenfassend kann man sagen, dass ChatGPT ein leistungsfähiges und nützliches Tool ist, aber auch einige Schwächen aufweisen kann. Wie bei jeder Technologie ist es wichtig, die Vor- und Nachteile gegeneinander abzuwägen und das Modell entsprechend einzusetzen.