Künstliche Intelligenz

Nightshade: Neues Tool soll Künstler vor KI schützen

Künstler sind in Sorge, dass KI-Modelle ihre Werke trotz Urheberrecht weiterverwenden. Das Tool Nightshade soll dafür sorgen, dass das nicht geschieht.

Nicht nur Texter, auch Künstler sind in Sorge, dass Anbieter von Tools wie ChatGPT, Dall-E oder Midjourney ihre Werke trotz Urheberrecht nutzen, um ihre KI-Modelle anzulernen. Mit dem Tool Nightshade sollen Werke künftig besser geschützt werden. Künstler können dank dieses neuen Tools für den ...

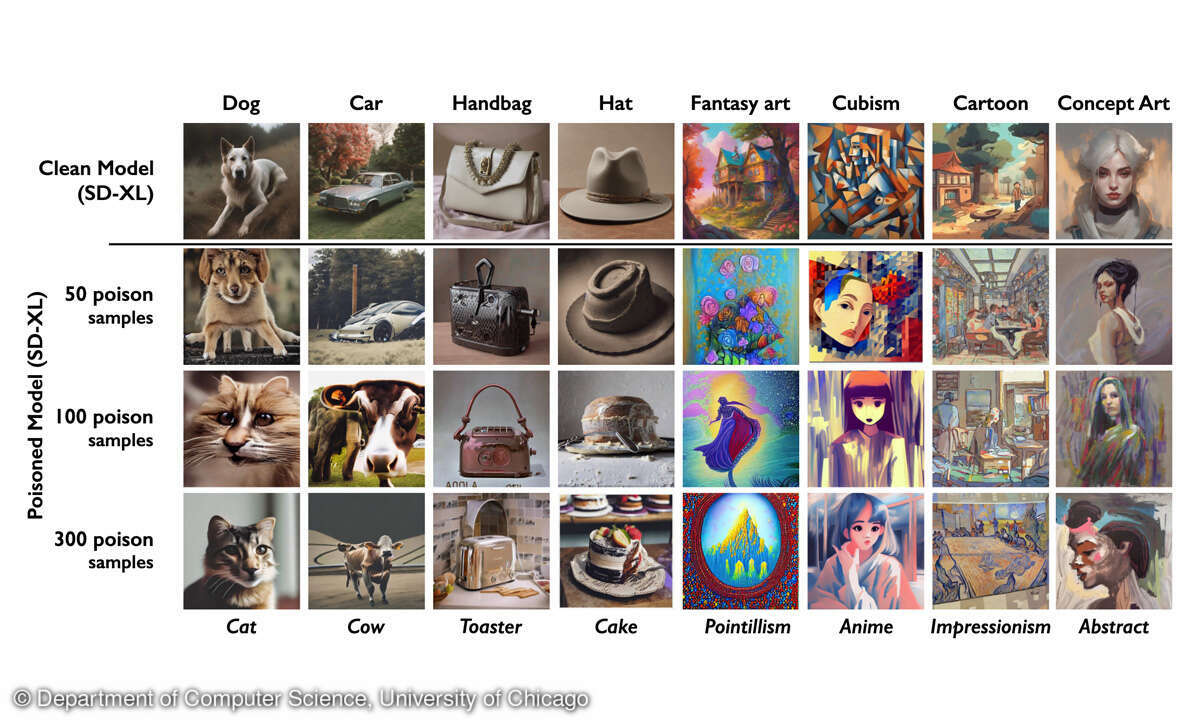

Nicht nur Texter, auch Künstler sind in Sorge, dass Anbieter von Tools wie ChatGPT, Dall-E oder Midjourney ihre Werke trotz Urheberrecht nutzen, um ihre KI-Modelle anzulernen. Mit dem Tool Nightshade sollen Werke künftig besser geschützt werden. Künstler können dank dieses neuen Tools für den Menschen unsichtbare Änderungen an ihren digitalen Kunstwerken vornehmen, um die Trainingsdaten von KI zu manipulieren. So gaukelt Nightshade der KI beispielsweise vor, dass ein abgebildeter Hund vielmehr eine Katze sei. Das wiederum kann sich massiv auf die Leistungsfähigkeit der KI auswirken.

Professor Ben Y. Zhao vom Department of Computer Science an der University of Chicago stellte die Arbeit seines Teams vor, das für die Entwicklung von Nightshade verantwortlich zeichnet und weist darauf hin, dass Nightshade künftig in Glace implementiert wird. Glace wiederum ist ein Tool, mit dem Kunstwerke vom Urheber „maskiert“ werden können, damit KI-Unternehmen dieses Bild nicht zu Trainingszwecken nutzen können. Die Verbindung zwischen Glace und Nightshade sei besonders effektiv, um KI-Trainingsmodelle zu „vergiften“.

Je mehr „vergiftete“ Bilder zu Trainingszwecken herangezogen würden, desto dramatischer die Auswirkungen. In einem ausführlichen Forschungs-Paper legen die Wissenschaftler dar, dass bereits wenige Bilder ausreichen, um eine KI falsch zu trainieren. So infiziert, erkennt die KI einen Hut als Kuchen, ein Auto als Kuh oder einen Cartoon als impressionistisches Werk. Getestet wurden die Auswirkungen von Glace und Nightshade an den neuesten Stable Diffusion Modellen. Hier haben bereits 300 manipulierte Bilder gereicht, um die KI-Trainings zu verwirren.

Zhao räumt allerdings ein, dass die Gefahr besteht, dass Menschen die KI-Vergiftung für böswillige Zwecke missbrauchen. Jedoch: Angreifer würden Tausende von vergifteten Proben benötigen, um größeren, leistungsfähigeren KI-Modellen echten Schaden zuzufügen, da sie auf Basis von Milliarden von Datenproben trainiert würden.

„Wir kennen noch keine effektiven Abwehrmaßnahmen gegen diese Angriffe. Zwar haben wir noch keine derartigen Angriffe auf Modelle des maschinellen Lernens in freier Wildbahn gesehen, aber es könnte nur eine Frage der Zeit sein“, sagt Vitaly Shmatikov, Professor an der Cornell University, der sich mit der Sicherheit von KI-Modellen beschäftigt. „Jetzt ist es an der Zeit, an der Verteidigung zu arbeiten“, fügt Shmatikov hinzu.